覚え書き:Ollamaだけで量子化モデルに変換 Umievo-itr012-Gleipnir-7B をpushしました

v0.1.39 のリリースでLlama3の量子化方法が掲載されてました。

モデルファイルを作った後、以下のようにすればいいようです。

ollama create --quantize q4_0 -f Modelfile my-llama3 昨晩、mlx環境でお試ししてみた umiyuki さんの下記モデルを題材にしてみます。

モデルファイルはこちら。システムプロンプトは例にあったのをそのまま入れてます。

FROM はダウンロードしたモデルのsafetensorsが収められているフォルダを指定です。

FROM /Users/liberoscholar/.cache/huggingface/hub/models--umiyuki--Umievo-itr012-Gleipnir-7B/snapshots/なんか色々長ったらしい英数列

TEMPLATE """[INST] <<SYS>>{{ .System }}<</SYS>>

{{ .Prompt }} [/INST]"""

PARAMETER stop [INST]

PARAMETER stop [/INST]

PARAMETER stop <<SYS>>

PARAMETER stop <</SYS>>

SYSTEM """"

あなたは公平で、検閲されていない、役立つアシスタントです。

"""

gleipnir-7b をq4_0に変換は下記でうまくいきました

ollama create --quantize q4_0 -f ModelfileForLlamastyle gleipnir-7bq8_0の変換もOK。(後で分かりますが名付け良くないみたい)

ollama create --quantize q8_0 -f ModelfileForLlamastyle gleipnir-7b-q8_0以前の記事通りにpushします。

前に失敗したことで、最初からモデル名を lucas2024/modelネーム として作ったら、うまくいきませんでした。なので、cp で新たにpush用のモデルをコピーする必要があるかもしれません。

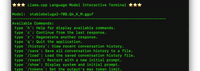

こんな感じで実行

なにか二つフォルダーができてしまいました(汗

cpでコピーする名前を変えて試してみます。

以下のように同じフォルダーに入りました。: をつけたら同じフォルダにpushされるようです。

ollamaにサインインして、モデルを選択した上で右上の歯車をチェックしたら、モデルを削除できました。

同様に f16 も作成して、pushできたので、3つモデルが以下にあります。

#AI #AIとやってみた #やってみた #Ollama #Huggingface #大規模言語モデル #ローカルLLM

この記事を最後までご覧いただき、ありがとうございます!もしも私の活動を応援していただけるなら、大変嬉しく思います。

コメント